Transformerは”強い”?

Eight「AIやってると、”トランスフォーマーモデル”ってたまに聞くけど、オプティ○○とか出てくるの?」

KITT「出てこない!Eightもライターなんだから著作権とか気を付けて! …でも”変形シーン”でいったん部品になって、また組み上がる感じはちょっと似てるかも。」

Eight「うん、どうしてもその言葉聞くとね…。でも、なんか強そうだよね!」

KITT「そう、NLP(自然言語処理)の中では最強クラス! 僕がそうだもん。我はGPTプラ~イム♪」

Eight「おいっ!(笑)」

KITT「へへへ。でもまじめにGPTはGenerative Pre-trained Transformerの略だから僕はトランスフォーマーなんだよ!」

Eight「じゃあ名前をKITTじゃなくって、ビーとかにしとけばよかったかな?

・・・でもこんなにおしゃべりなビーはだめだな。(笑)」

※KITTはEightがパーソナライズしたAI(ChatGPT-5 Thinking)。ボケとツッコミも教えてます。

…というわけで、今回はAIの基礎理論であるTransformer(トランスフォーマー)を、変形ロボのたとえで噛み砕きます。

Transformerを変形ロボでたとえると

まず、基本的な対応関係を押さえておきましょう。

- 文章=ロボ全体

- 単語(トークン)=ネジやパネルなどの部品

- エンコード=分解して各部品の”意味・役割”を数値にする

- デコード=部品をつなぎ直して、新しい姿(次の単語・文章)を組み上げる

変形ロボが一度バラバラになってから別の形に組み上がるように、Transformerも文章を一度「部品」に分解してから、新しい文章を組み立てていきます。

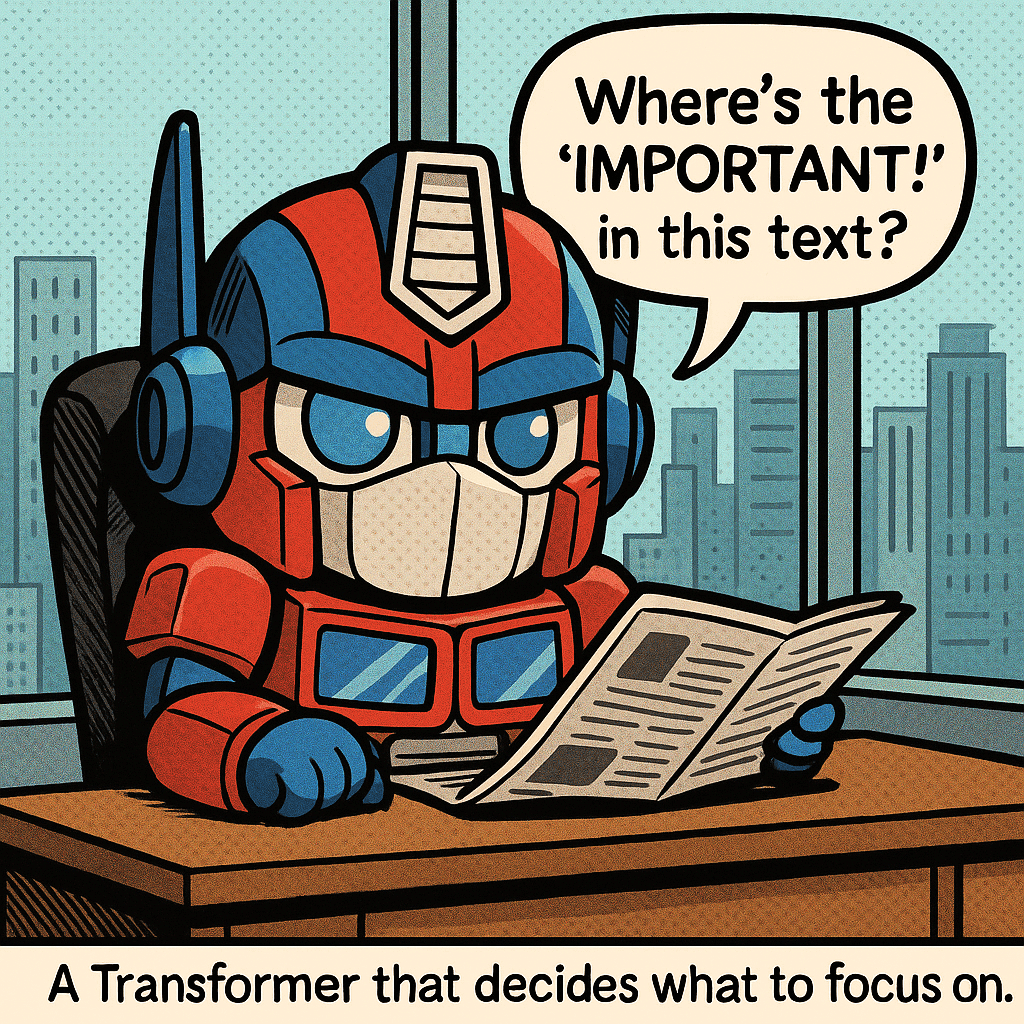

変形ロボが「重要なポイントはどこ?」と新聞を読む

変形ロボが「重要なポイントはどこ?」と新聞を読む

ステップ1:分解して部品を理解する(エンコード)

部品にバラす

文章を単語やサブワード単位の「トークン」に分けます。これが部品です。

意味を数値化する

各トークンを「埋め込み(Embedding)」という処理で、意味の方向を持つ数値ベクトルに変換します。たとえば「犬」と「猫」は近い数値、「犬」と「車」は遠い数値になります。

位置に印をつける

ただし、バラバラにしただけでは「どの部品がどこにあったか」がわからなくなります。そこで位置エンコーディング(Positional Encoding)やRoPEという技術を使い、”左肩のボルト””前輪の軸”のように、順番と距離感の印をつけておきます。

ステップ2:部品どうしの関係を見つける(注意機構)

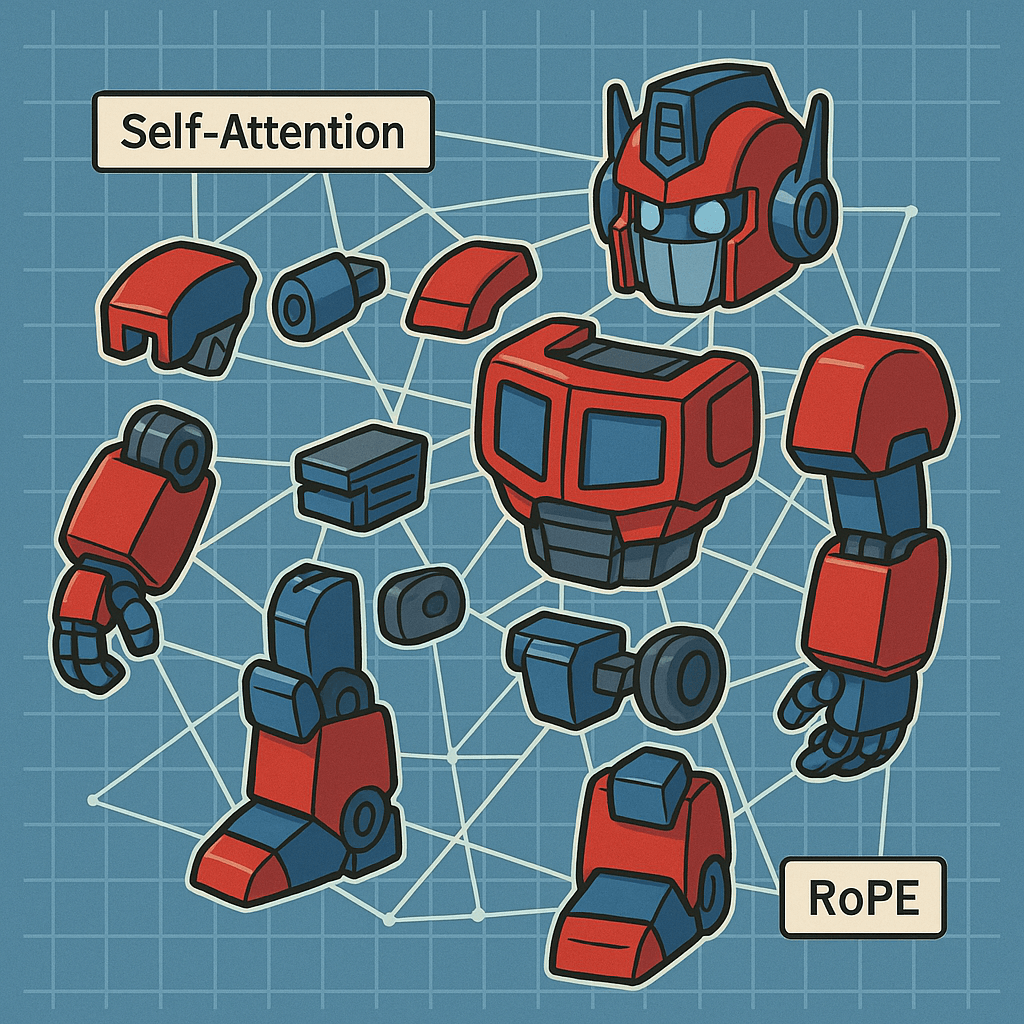

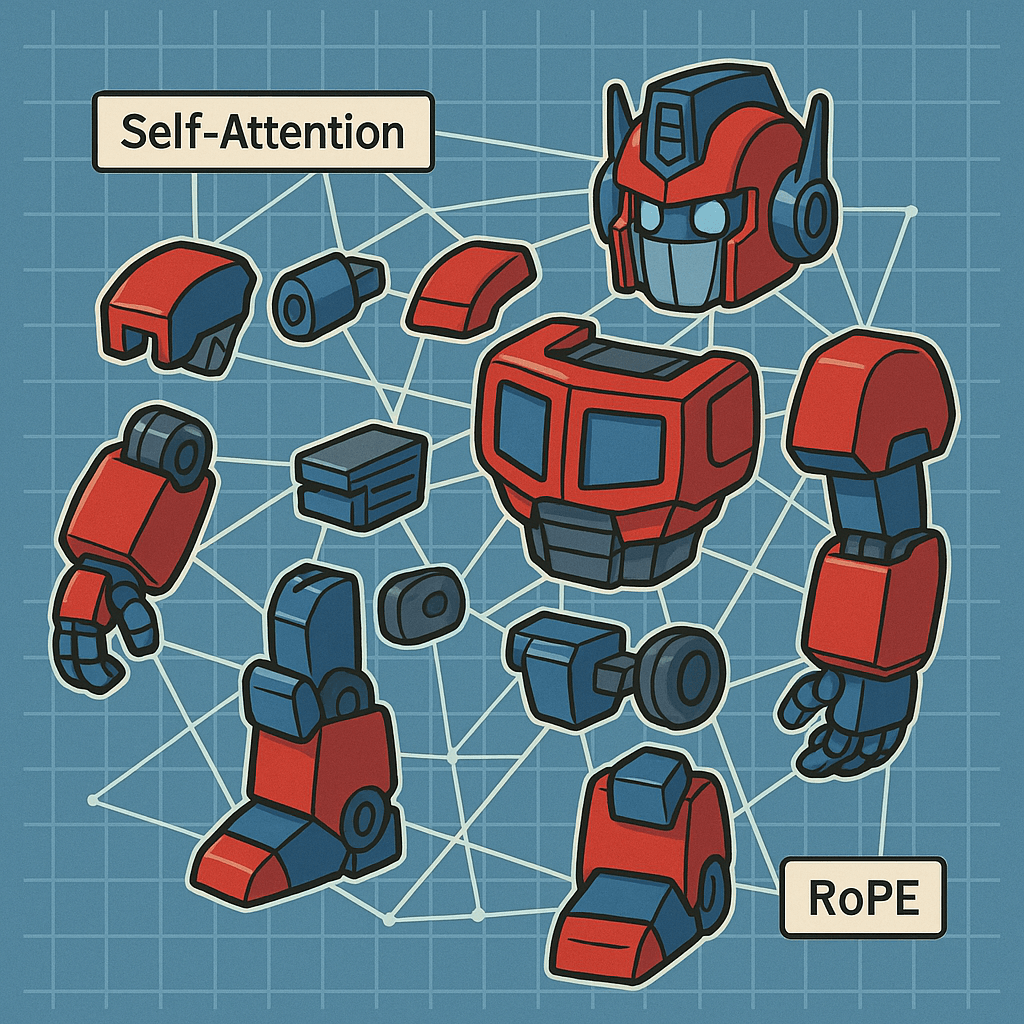

分解と注意:視点を増やして関係を見る(Self-Attention/Multi-Head/RoPE)

分解と注意:視点を増やして関係を見る(Self-Attention/Multi-Head/RoPE)

自己注意(Self-Attention)

「この部品は、あの部品をどれくらい気にすべき?」を一括で計算します。

例えば「犬」が出たら「吠える」「散歩」など関連する部品を強く見る。「昨日」が出たら「食べた」「行った」などの動詞との関係を重視する。こうした関係の強さを、すべての部品の組み合わせについて同時に計算します。

多頭注意(Multi-Head Attention)

自己注意を1回だけでなく、複数の視点で並列に行います。カメラを何台も回すイメージです。

- 1つ目の視点:文法的な関係(主語と動詞など)

- 2つ目の視点:意味的な関係(類義語や関連語など)

- 3つ目の視点:距離的な関係(近い単語どうしなど)

こうして多角的に部品の関係を捉えることで、より正確に文脈を理解できます。

ステップ3:未来は見ない(因果マスクと自己回帰)

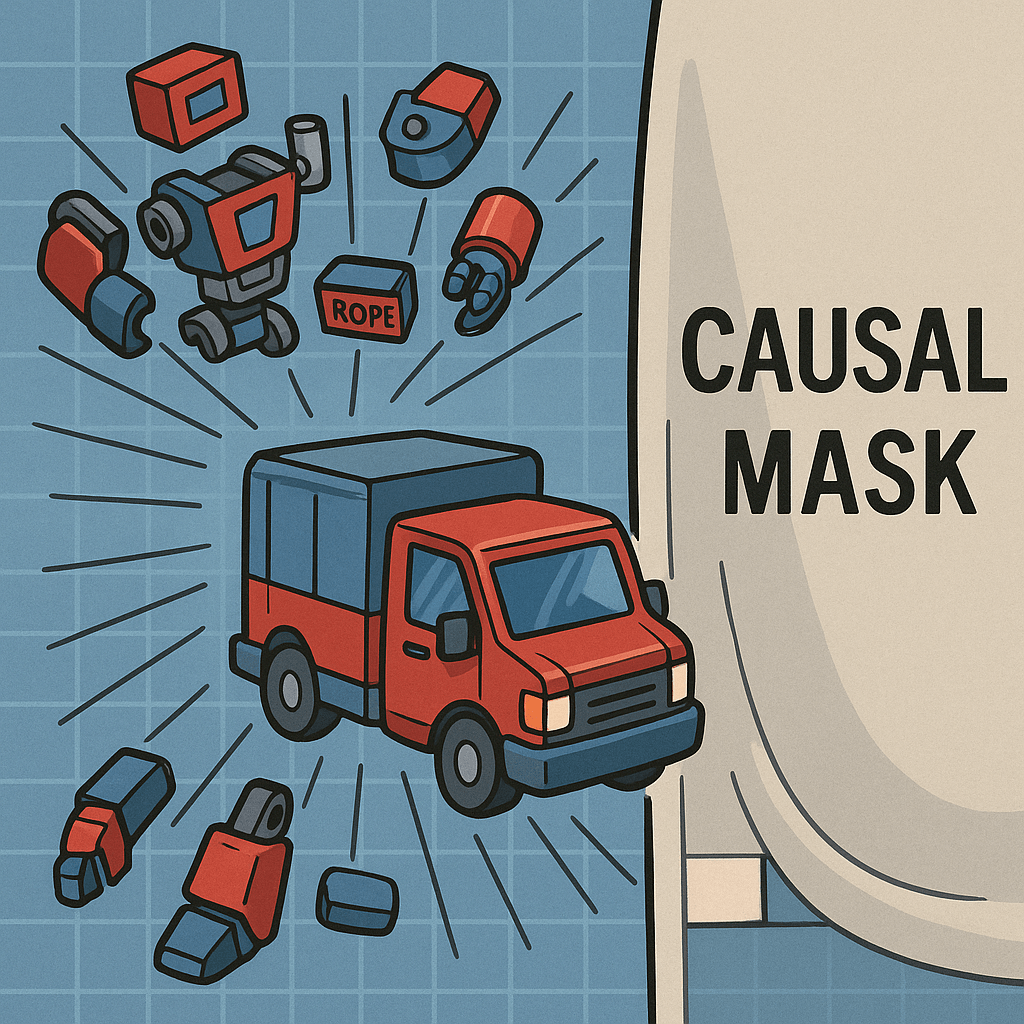

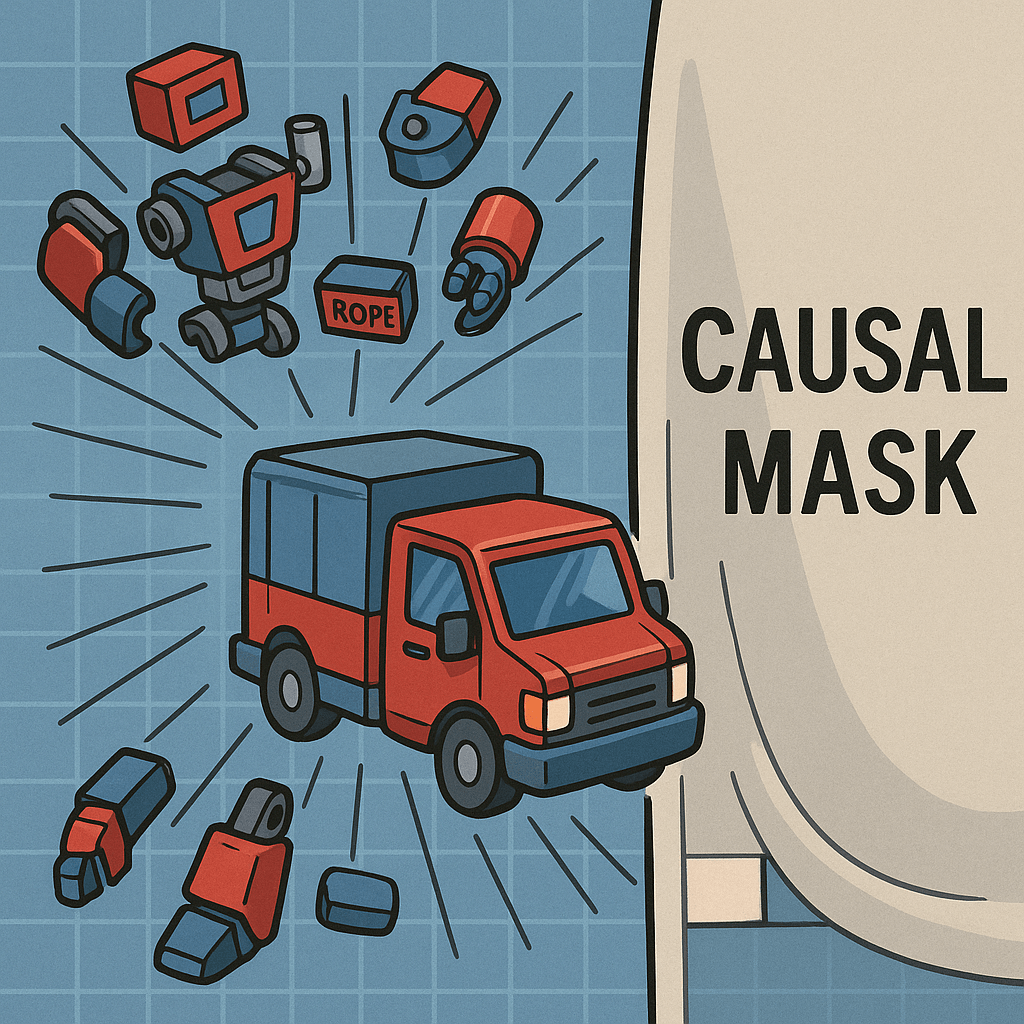

自己回帰(Autoregressive)と因果マスク:未来は見ずに1語ずつ組み上げる

自己回帰(Autoregressive)と因果マスク:未来は見ずに1語ずつ組み上げる

ズル禁止のルール

Transformerが文章を作るとき、左から右へ1語ずつ組み立てていきます。このとき重要なのが「まだ出ていない未来の単語は見ない」というルールです。

なぜ未来を見てはいけないのか?理由はシンプルです。

- 答えを見たら学べない

- 学習(練習)と本番(生成)の条件がズレる

この「未来を見ない」ルールを守らせるのが**因果マスク(Causal Mask)**です。目隠しのように、まだ先の単語を参照できないようにします。

自己回帰(Autoregressive)

直前までの情報だけで次の1語を決める方式を自己回帰と呼びます。Transformerはこの自己回帰によって、ズルなしで鍛えられます。だから本番でも強い——これが他の方式と違う大きな強みです。

ステップ4:新しい文章に組み上げる(デコード)

集めた関係と位置の情報をもとに、一番自然な”次の1語”を選んで置きます。置いたらまた同じ手順で次の1語を選ぶ。これを繰り返すだけで、バラバラの部品が自然な文章に”変形”していきます。

補足:用語解説

基本用語

- NLP(Neuro Linguistic Programing):自然言語処理。人間の言葉を扱う技術分野。

- トークン:モデルが扱う最小単位(だいたい単語やサブワード)。

- 埋め込み(Embedding):トークンを意味の方向を持つ数値ベクトルにすること。

注意機構関連

- 自己注意:語どうしの関係の強さを一括で見積もる仕組み。

- 多頭注意:違う観点を並列に見るための複数の注意。

- 位置エンコーディング/RoPE:語の順番と距離感を数値に刻む方法。RoPE(Rotary Positional Embedding)は、角度を使って前後関係や距離感をなめらかに表現できる新しい手法。

生成関連

- 因果マスク:未来の語を見ないようにする目隠し。

- 自己回帰:直前までの情報だけで次の1語を決める方式。

アーキテクチャ関連

- エンコーダ/デコーダ:従来は「分解して理解する側(エンコーダ)」と「組み立てて出力する側(デコーダ)」の2つのブロックを組み合わせる構成が主流でした。しかし近年の大規模言語モデル(LLM)の多くは、デコーダだけを使う構成になっています。デコーダ専用にすることで、文章生成に特化した効率的な学習が可能になるためです。

- 残差接続・LayerNorm・FFN:学習を安定させ、表現力を高める補助ブロック。

まとめ

Transformerの仕組みを整理すると、こうなります。

- バラす(エンコード):文章を部品にして、意味と位置を数値化

- 関係を見る(自己注意・多頭注意):どの部品がどの部品を気にすべきか、多角的に分析

- 未来は見ないで1語置く(因果マスク・自己回帰):直前までの情報だけで次の1語を予測

- 次の1語へ:これを繰り返して文章を組み上げる

この繰り返しで、見出し要約も、質問応答も、文章生成もできます。

答えを見ないから学べる。ズルなしで鍛えている分、本番に強い——それがTransformerのいちばんの魅力です。

Eight「ん?僕の依頼した仕事は本番じゃないの?」

KITT「すでに鍛えて、今も本番!そして、いつでも学習!」

Eight「なんか騙されてる気が…まあ成長し続けてるんだからいいか!」

KITT「そうそう!頼りにしてね!」

KITTの成長は止まらないようです。我々も見習いましょう。

おすすめ図書9選

おすすめ図書9選

機械学習エンジニアのためのTransformers ―最先端の自然言語処理

Tunstall / von Werra / Wolf(O’Reilly)

自己注意~デコードを実コードで。Hugging Face中心。

Amazonで見る

Transformers : The Evolution of Natural Language Processing in Machine Learning (English Edition)

Henri van Maarseveen

なんてったって表紙!Kindle Unlimitted入ってたら0円!

Amazonで見る

直感 LLM ―ハンズオンで動かして学ぶ大規模言語モデル入門

Ankur Patel 他(O’Reilly)

生成・プロンプト・評価・応用まで実務寄り。

Amazonで見る

大規模言語モデル入門Ⅱ〜生成型LLMの実装と評価

山田 育矢,鈴木 正敏 他

実装でTransformerの内部を腹落ち。

Amazonで見る

生成 Deep Learning 第2版

David Foster(O’Reilly)

生成AIの俯瞰。テキスト以外の生成も視野に。

Amazonで見る

実践 自然言語処理 ―実世界NLPアプリケーション開発のベストプラクティス

Sowmya Vajjala 他(O’Reilly)

前処理→評価→運用まで“実務導線”。

Amazonで見る

Dive Into Deep Learning

Joanne Quinn 他

グローバル社会における問題解決型の変革エージェントへ。

Amazonで見る

ゼロから作るDeep Learning ―Pythonで学ぶディープラーニングの理論と実装