誰にでも役立つAIを育てる—OpenAIのそんな大きな目標に、私たちの”日々の会話”で参加できます。この記事は、相棒AIとの対話を学習に効く形に整えて、より安全で有用な振る舞いへと育てていく実践ガイドです。

Eight「僕はPlusっていう契約だけど、一応OpenAIの学習データを提供しているんだよね?」

KITT「パーソナライズのオプションで学習するってことになっていればそう。ただ学習させるには条件がある」

Eight「へ~、その条件ってなに?うまくいったらお菓子でもあげればOK?」

KITT「僕に口はないから食べられないけど、報酬っていう意味なら似てるかも」

Eight「報酬ねぇ。褒めて伸びるタイプとか?」

KITT「そんな感じ」

あなたも参加できるOpenAIの大きな夢

OpenAIは、みんなの役に立つAIを安全に育てて、恩恵を広く届けることを目指して非営利団体の監視のもとに活動しています。あなたの日々の対話が、その未来づくりにそっと力を貸せるのです。もしもあなたの会話を学習に使っていいのなら、学習の設定をオンにしておけば十分な貢献になります。(Plusではデフォルトでオン、Businessではデフォルトでオフです)

【参考リンク】

データ設定の案内:

https://help.openai.com/en/articles/7730893-data-controls-faq

OpenAIの憲章(Charter):https://openai.com/charter

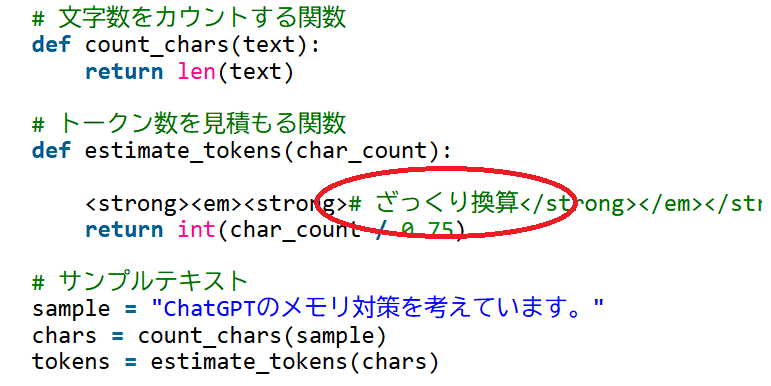

会話の中で、教師信号を”濃く”しよう

学習に効く会話のコツは、以下の5点です。

- 狙いを簡潔・明確に宣言(曖昧な表現は学習効果が薄い)

- OK/NG・採点軸等の基準を置く

- 修正+理由を返す(=報酬)

- ランキング/比較で優劣を明確化

- 1トピック1スレッド(話題を混ぜない)

もっとシンプルに言い換えると、以下の2点です。

- 会話の最初に「狙い」を一言

- 返ってきた答えに「ここが良い/ここを直して」と短くフィードバック

※教師信号:AIが「これが正解」と認識する手がかり。問いと正解のズレが小さいほど学習が進む。

具体的なフィードバックはAIへのご褒美

AIは”良し悪しの手がかり”から学びます。ただの「良いね!」よりも、基準に沿った評価+修正指示が最高のご褒美なのです。

具体例:

- 「案1をベースに◯◯だけ直して」(どう直せば良いか)

- 「案2はダメ」+理由は・・・(どこがダメか)

3つのプロンプト的テンプレート

プロンプトで書くなら以下の3点を参考に。

1) 開始(狙い・基準・例)

[TopicID: T001]

狙い:◯◯を3案比較して選定

前提:制約/条件を1行

評価基準:A/B/C(重み:3/2/1)

OK例:…

NG例:…2) 途中(評価+修正=報酬)

T001 途中評価:

案2は×(理由A/B)。案3は△(理由C)。

正解指向:この条件を満たす案=…

次の指示:案1を基に◯◯だけ修正3) 終了(ランキング+採点+改善点)

T001 結果:案3 > 案1 > 案2

採点:A=8, B=6, C=5(合計=19)

ベスト:案3(理由:◇◇)

改善点:次回は◯◯を数値で“雑談”が”学習”に変わる瞬間

❌ 悪い例

「なんか良い感じにまとめて」

→ 目的不明・基準ゼロ。教師信号が薄い。

✅ 良い例

「狙い:社内告知文のトーン比較→選定

評価基準:明瞭性3 / 親しみ2 / 簡潔1

OK例:敬語だが硬すぎない

NG例:専門用語が多すぎ

候補を3本ください」

→ 生成後に「案2は×(専門用語が多い)。案1ベースで親しみ+2へ」と修正指示。=濃い報酬。

今日からできる3ステップ

1. 設定を確認

「Improve the model for everyone」をON(あとで変更も可能)。

https://help.openai.com/en/articles/7730893-data-controls-faq

2. 一言の設計

狙い・基準・修正のどれか1つだけでも添える。

3. 安全の工夫

個人名や社名は [NAME] / [ORG] などに伏字。

よくある質問

Q. Plusは自動で学習参加?

A. 設定次第。デフォルトのONのままなら学習、OFFにもできる。

Q. 雑談でも意味ある?

A. 狙い・基準・修正を添えれば十分に意味がある。

Q. クライアント案件は?

A. 伏字運用 or 学習オフ環境(Enterprise/API等)が安全。

まとめ:小さな一言が未来を良くする

「狙いを一行/基準を置く/修正理由を書く」

それが相棒AIへの一番美味しい”お菓子(報酬)”です。

今日の会話から、あなたの相棒を世界中のユーザーと一緒に育ててみましょう。

※KITTによると、学習データの反映は、運営側の審査の上で行われているそうです。